La inteligencia artificial es una tecnología que, si se usa de un modo adecuado, nos puede traer grandes beneficios. Y en este post hacemos un repaso a las diferentes implementaciones de la IA, que ya estamos usando dentro del ecosistema de productos, y que nos han facilitado la vida sin que nos demos cuenta.

Toda tecnología exitosa, tiende a volverse invisible. Y en el caso de la inteligencia artificial, las implementaciones que Apple ha llevado a cabo, a día de hoy ya las usamos sin prácticamente darnos cuenta, gracias a su facilidad de uso y a su integración con el hardware y el software de los productos de la manzana.

No necesitamos megapixeles gracias a la IA

Los procesadores de Apple derrochan potencia. Pero también integran IA como parte de ese rendimiento. Y una de las aplicaciones prácticas que tenemos son las fotos que tomamos con la cámara. Las lentes de los iPhone, hasta los iPhone 14 Pro, han contado siempre con 12 megapixeles. Ahora bien, ¿Por qué sacan fotos tan buenas con tan «poca» resolución?

Esto es gracias al sistema de procesado de fotos. El sistema HDR inteligente, el Modo Acción, el Modo Cine o la estabilización por software son posibles a los procesadores Bionic, que incorporan sistemas de IA. Apple lo engloba bajo el concepto de Fotografía Computacional, término acuñado en el año 2019 cuando presentaron los iPhone 11 y 11 Pro.

El iPhone que aprende de nosotros

Tradicionalmente, un software no «aprendía» y «se mejoraba» a sí mismo. Pero esto cambió con la IA. Y es que, gracias a la implementación de este sistema en el iPhone, ahora el teléfono aprende mejor de nuestros hábitos.

Desde la ubicación o la hora, para recomendarnos un modo de concentración, la hora a la que nos vamos a dormir y dejamos de usar el teléfono para cargarlo de una forma más optimizada, e incluso, las aplicaciones que utilizamos más, para que se nos muestren accesos más directos a ellas.

Y todo esto, en segundo plano, sin consumir a penas recursos y sin enviar la información a terceros. Todo queda dentro del procesador del iPhone, ya que este tiene la capacidad de conocer cómo manejamos el dispositivo, y se adapta a lo que nosotros hacemos con él.

Las imágenes y los textos

Aunque ahora ya está mucho más integrado, en su momento fue una auténtica «voladura de sesos». Y es que tenemos la posibilidad de, en una imagen o en un vídeo, de poder seleccionar texto para copiarlo en otro sitio.

O también, podemos recortar una imagen, quitándole el fondo, tan sólo seleccionando el ítem de la foto o el vídeo que queremos. Tareas que antes requerían de mucho tiempo y accesorios de terceros, ahora las hacemos con tan sólo pulsar un dedo.

Los deepfakes

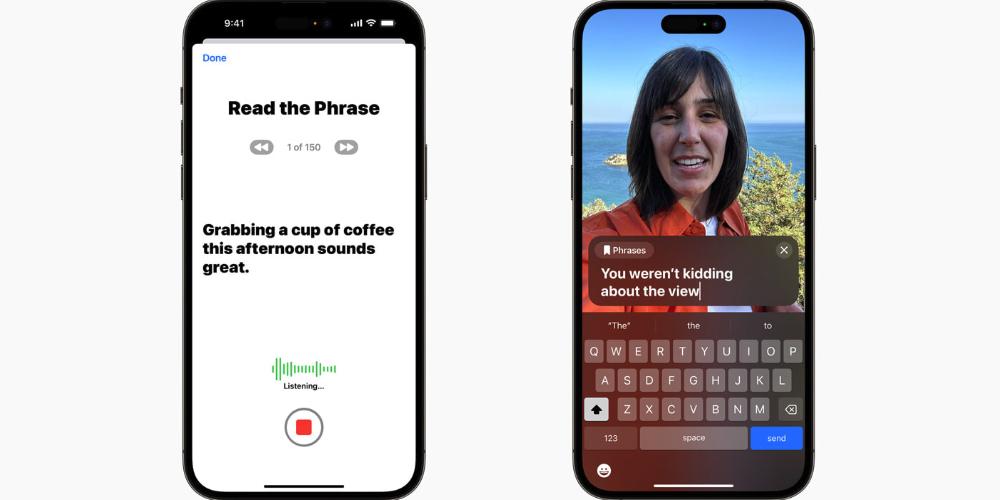

Sí. Aunque los deepfakes tienen connotaciones negativas, lo cierto es que Apple ha conseguido darle una vuelta al término y a todo lo que conlleva. Uno de los mejores ejemplos es la posibilidad de crear una voz sintética, directamente en el iPhone, utilizando nuestra voz. Gracias a nuestras grabaciones, la IA crea una voz que suena como la nuestra, y sus aplicaciones están enfocadas en la accesibilidad.

Y de la voz, pasamos a la imagen. Y aunque no hayamos visto esto en acción, lo que nos enseñaron promete (y mucho). En el caso de las Apple Vision Pro, cuando hacemos una videollamada con las gafas puestas, la otra persona ve nuestro rostro completo. No se trata de una avatar o de un reader en 3D, sino de una digitalización de nuestra cara. Una vez más, gracias al uso de la IA.