Apple mejorará el control de las Vision Pro gracias a esta función patentada

El nuevo visor de computación espacial y realidad mixta de los californianos, las Apple Vision Pro, estarían más cerca que nunca. Sin embargo, aunque estén a punto de ver la luz de forma pública el próximo 2024, eso no es un impedimento para que sigan desarrollándose avances y se registren patentes para mejorar el funcionamiento. ¿Quieres conocer todos los detalles? En este artículo te los vamos a dar a conocer.

Ha sido el medio especializado Patently Apple quién se ha hecho eco de los documentos que han sido registrados en la Oficina de Patentes y Marcas de los Estados Unidos. El más importante, y el que te venimos a explicar se llama «Activación de ítems accionables con gestos manuales».

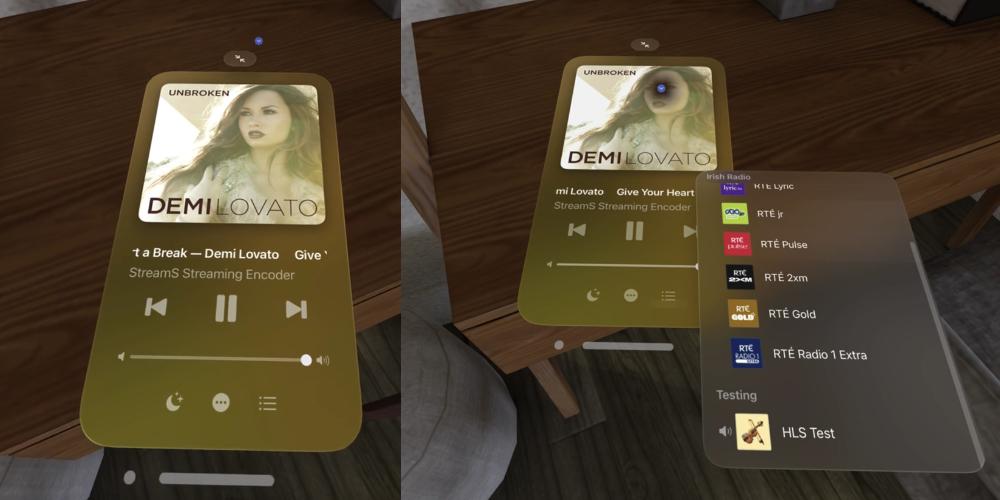

La interacción de las Apple Vision Pro se basa en tomar los elementos de la realidad material y poder vitaminarlos con componentes del entorno digital. Mediante nuestras manos vamos a poder realizar gestos que las gafas van a detectar a través de los sensores, además de que podremos colocar elementos de interfaz digital sobre superficies materiales, para así poder tener un control completo. Ahora, con esta invención, quieren dar un paso más.

Detección y activación de objetos

El funcionamiento básico de esta patente consiste en «recibir, desde un sensor de imagen, una o más imágenes del entorno físico», y a partir de ahí, estas se relacionan con diferentes acciones que se pueden desarrollar si ejecutamos el comando correcto, que en este caso son gestos manuales.

En las imágenes que se muestran de la patente se observa un entorno físico, en el cual hay diferentes tipos de objetos distribuidos. Con las gafas Apple Vision Pro puestas, a estos elementos se les superponen interruptores virtuales, puntos, que nosotros mismos podemos seleccionar para ejecutar diferentes tareas.

Se trata, pues, de una patente que se desarrolla en base al software, que en el caso del visor de realidad mixta es visionOS. También se observa un boceto de las Vision Pro, junto con todas las ubicaciones de los sensores que serán capaces de captar los elementos de nuestra realidad tangible, así como también, el campo de visión operativo que va a estar disponible para poder interactuar de forma directa.

Uno de los ejemplos que se ilustran, de cara al uso práctico, es una lista de teléfonos en la que podemos seleccionar el contacto que queremos, para poder realizar una llamada de forma directa. Esto también es un indicador de la profundidad de interacción de los diferentes dispositivos de Apple. El Mac, el iPad y el Apple Watch son capaces de realizar llamadas de teléfono cuando están enlazados a un iPhone, en la misma red de conexión inalámbrica.

Por el momento, sólo conocemos estos datos a través de la patente. Queda, todavía, un tiempo para que podamos ver estos avances materializados en la interfaz. Así pues, una de las fechas clave para el visor de realidad mixta es febrero del 2024, y será a partir de ahí donde podamos conocer con más detalle el cómo se llevan a cabo estas interacciones.